Здравствуйте, уважаемые читатели блога «Мир Вебмастера»! Файл robots.txt – это очень важный файл, напрямую влияющий на качество индексации вашего сайта, а значит и на его поисковое продвижение. Именно поэтому вы должны уметь правильно оформлять роботс.тхт, чтобы случайно не запретить к индексу какие-нибудь важные документы интернет-проекта.

О том, как оформить файл robots.txt, какой синтаксис нужно использовать при этом, как разрешать и запрещать к индексу документы, и пойдет речь в этой статье.

О файле robots.txt

Сначала давайте подробнее узнаем, что же это за файл такой.

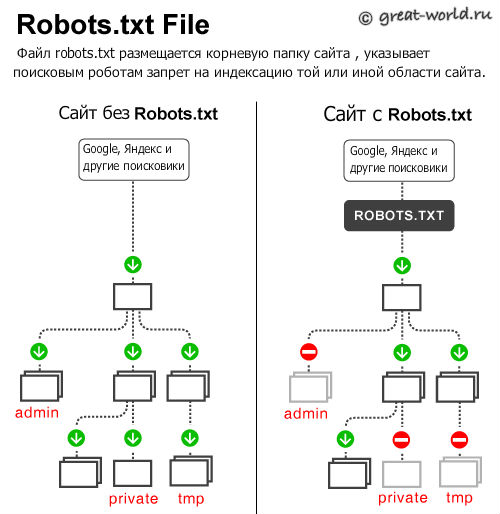

Файл роботс – это файл, который показывает поисковым системам, какие страницы и документы сайта можно добавлять в индекс, а какие – нельзя. Он необходим из-за того, что изначально поисковые системы стараются проиндексировать весь сайт, а это не всегда правильно. Например, если вы создаете сайт на движке (Wordpress, Joomla и т.д.), то у вас будут присутствовать папки, организующие работу административной панели. Понятно, что информацию в этих папках индексировать нельзя, как раз в этом случае и используется файл robots.txt, который ограничивает доступ поисковикам. Также в файле роботс.тхт указывается адрес карты сайта (она улучшает индексацию поисковыми системами), а также главный домен сайта (главное зеркало).

Зеркало – это абсолютная копия сайта, т.е. когда один сайт склеен по двум доменам, то говорят, что один из них – это главный домен, а другой – его зеркало. Таким образом, у файла достаточно много функций, причем немаловажных!

Синтаксис файла robots.txt

Файл роботс содержит блоки правил, которые говорят той или иной поисковой системе, что можно индексировать, а что нет. Блок правил может быть и один (для всех поисковиков), но также их может быть несколько – для каких-то конкретных поисковиков отдельно.  Каждый такой блок начинается с оператора «User-Agent», который указывает, к какой поисковой системе применимы данные правила.

Каждый такой блок начинается с оператора «User-Agent», который указывает, к какой поисковой системе применимы данные правила.

User-Agent: A {правила для робота «А»} User-Agent: B {правила для робота «В»} В примере выше показано, что оператор «User-Agent» имеет параметр – имя робота поисковой системы, к которой применяются правила. Основные из них я укажу ниже:

| Поисковая система | Имя робота |

| Для всех | * |

| Яндекс | Yandex |

| Гугл | GoogleBot |

| Mail.ru | Mail.Ru |

| Рамблер | StackRambler |

| Яху | Slurp |

После «User-Agent» идут другие операторы. Вот их описание:

| Оператор | Назначение |

| Disallow | Запрещает индексировать указанные разделы |

| Allow | Оператор, обратный Disallow, разрешающий индексировать указанные разделы сайта. Allow необязателен, поисковик и так проиндексирует все что вы не запретили оператором Disallow. |

| Host | Указывает главный домен сайта (главное зеркало). |

| Sitemap | Указывает адрес карты сайта. |

Для всех операторов справедлив один синтаксис. Т.е. операторы нужно использовать следующим образом: Оператор1: параметр1 Оператор2: параметр2 … Таким образом, сначала мы пишем название оператора (неважно, большими или маленькими буквами), затем ставим двоеточие и через пробел указываем параметр данного оператора. Затем с новой строки таким же образом описываем оператор два.

Важно!!! Пустая строка будет означать, что блок правил для данного поисковика закончен, поэтому не разделяйте операторы пустой строкой.

Пример файла robots.txt

Рассмотрим простенький пример файла robots.txt, чтобы лучше разобраться в особенностях его синтаксиса:

User-agent: Yandex

Allow: /folder1/

Disallow: /file1.html

Host: www.site.ru

User-agent: *

Disallow: /document.php

Disallow: /folderxxx/

Disallow: /folderyyy/folderzzz

Disallow: /feed/

Sitemap: http://www.site.ru/sitemap.xml

Теперь разберем описанный пример. Файл состоит из трех блоков: первый для Яндекса, второй для всех поисковых систем, а в третьем указан адрес карты сайта (применяется автоматически для всех поисковиков, поэтому указывать «User-Agent» не нужно). Яндексу мы разрешили индексировать папку «folder1» и все ее содержимое, но запретили индексировать документ «file1.html», находящийся в корневом каталоге на хостинге.

Также мы указали главный домен сайта яндексу. Второй блок – для всех поисковиков. Там мы запретили документ «document.php», а также папки «folderxxx», «folderyyy/folderzzz» и «feed». Обратите внимание, что мы запретили в втором блоке команд к индексу не всю папку «folderyyy», а лишь папку внутри этой папки – «folderzzz». Т.е. мы указали полный путь для «folderzzz». Так всегда нужно делать, если мы запрещаем документ, находящийся не в корневом каталоге сайта, а где-то внутри других папок.

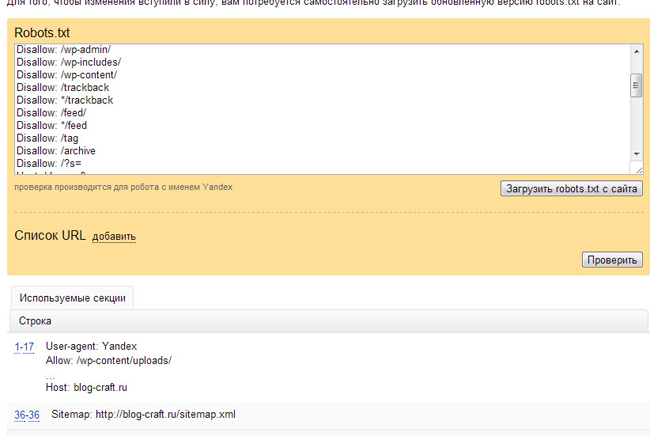

Создание займет меньше двух минут:Созданный файл роботс можно проверить на работоспособность в панели вебмастеров Яндекса. Если в файле вдруг обнаружатся ошибки, то яндекс это покажет.

Обязательно создайте файл robots.txt для вашего сайта, если его у вас до сих пор нету. Это поможет развиваться вашему сайту в поисковых системах. Также можете почитать еще одну нашу статью про способы запрета индексации методом мета-тегов и .htaccess. Известный блоггер Михаил Шакин подготовил видео-урок специально для тех кто пользуется движком WordPress: